לחימה המצאתית: חדשנות שיטתית בהגנה על רכב אוטונומי

26 ספטמבר, 2017

ככל שנחשפות החולשות של רשתות הבינה המלאכותית במכונית האוטונומית העתידית, מתברר שיש צורך לנקוט בגישת אבטחה המצאתית חדשה, המבוססת על טקטיקות לחימה שנוסחו לרשונה לפני יותר מאלפיים שנה

[בתמונה למעלה: "מלכודת למכונית אוטונומית" של ג'יימס ברידל]

מאת עמוס רדליך

ההתלהבות ממהפיכת הרכב האוטונומי מלווה בחששות רבים, שחלקם מקבל ביטוי אמנותי. לאחרונה פירסם האמן הבריטי ג'יימס ברידל (James Bridle) יצירה חדשה במסגרת פרוייקט האסתטיקה הדיגיטלית שבה הוא מתמקד בשנים האחרונות. היצירה הזו (בתמונה למעלה) קיבלה את הכינוי "מלכודת למכונית אוטונומית" (Autonomous Car Trap 001). ברידל הקיף את המכונית בפס הפרדה, כדי להראות שבאמצעות מהלך פשוט ולא מתוחכם, ניתן להטעות את מערכת החיישנים של הרכב ולגרום לו להיתקע במקומו ללא יכולת תנועה – כל עוד מופעלת מערכת המונעת מהרכב לסטות מהנתיב המסומן.

נקודה עיוורת ברשת הראייה הנוירונית

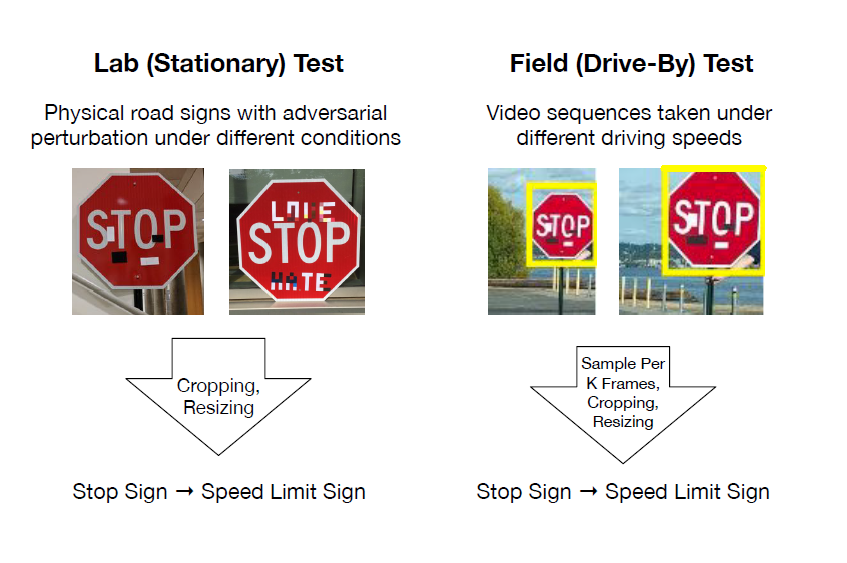

ברידל אינו הראשון המנסה להטעות את הטכנולוגיות המתוחכמות שיעמדו מאחורי הרכב האוטונומי. לאחרונה פירסמו מספר חוקרים מאוניברסיטאות בארצות הברית, מאמר המתאר שיטה פשוטה ויעילה להטעיית הרשתות הנוירוניות במערכות הבינה המלאכותית של רכב אוטונומי. המאמר בשם Physical Attacks on Deep Learning Models, חושף שיטת הטעייה שנחשבה עד לאחרונה לבתלתי אפשרית. מערכות הניתוח הנוירוניות יודעות לפענח תמרורים תוך כדי נסיעה, מזוויות שונות ובתנאי מזג אוויר שונים. לכן חבה פיסית נחשבה לא יעילה. למרות זאת החוקרים הצליחו לייצר סוגים של הפרעות, באמצעות מדבקות שונות על גבי השילוט, שגרמו לרשתות הנוירוניות (Deep Neural Networks) לבצע פיענוח שגוי.

כך למשל, הנחת שתי מדבקות שחורות קטנות בתצורה מתוכננת מראש על-גבי שלט עצור, גרמה למערכת הבינה הנוירונית לפענח את התמרור כתמרור המורה על מהירות מוגבלת של 45 מייל לשעה – ולא כתמרור המורה על עצירה מוחלטת. תוצאה דומה התקבלה גם באמצעות חבלה כמעט בלתי נראית לעין: החוקרים הסתירו את ההפרעה בתוך כתובת גרפיטי תמימה. עבור צופה מהצד הכתובת אינה נראית מאיימת אלא תוצאה של שובבות נעורים. הרשת הנוירנית מתייחסת אליה באופן שונה: היא יודעת להתעלם מהגרפיטי עצמו, אבל לא מההפרעה המתוכננת המוטבעת בתוך כתובת הגרפיטי – ומבצעת פיענוח שגוי של התמרור.

שתי הדוגמאות האלה מבהירות גם את האתגרים העומדים בפני מתכנני הרכב האוטונומי, אבל גם מרמזות על הפתרון: אחד האתגרים העומדים בפני יצרני הרכב האוטונומי הוא אבטחה. הרכב האוטונומי יהיה מקושר כשהתקשורת עם סביבתו תתנהל באמצעות סנסורים, פרוטוקולי אינטרנט או טכנולוגיית תקשורת כמו V2V, V2I, DSRC – Dedicated Short Range Communications וכדומה. הרשתות אלה חשופות בפני פצחנים חורשי רע, ולכן יצרני הרכב יידרשו להבטיח שהמידע ברשת הממונעת מגיע בשלמותו, ללא יכולת של צד שלישי לשנות או לעצור אותו.

לרוע המזל, "הבחורים הרעים" לא רק משפרים את יכולותיהם הטכנולוגיות, אלא הם גם בעלי יכולת חשיבה יצירתית ומקורית. בשנים האחרונות התפתח ענף ידע חדש בשם Adversarial example השואף לשבש אלגוריתמים במטרה לשפר את התכנון שלהם. כלים אלו יכולים להיות מנוצלים בצורה זדונית, כפי שראינו בדוגמא למעלה. הדבר דומה ל"פרדוקס השוטר והגנב": השוטר מתמחה במניעת פשעים שכבר בוצעו, בעוד הגנב מתמחה בהמצאת דרכים חדשות ומקוריות לבצע פשעים. כדי לא להילכד במלכודת "השוטר והגנב", צריכים מומחי הרכב האוטונומי לחשוב כמו גנבים – ולהמציא איומים על המערכות הקיימות.

טקטיקת לחימה המצאתית

אתגר זה מחייב שימוש בכלים חדשניים ובחשיבה המצאתית שאינם מקובלים כיום בתחום אבטחת המידע. אחד הכלים המתקדמים בתחום החדשנות השיטתית נקרא AFD – Anticipatory Failure Determination. הוא נועד לזהות, לנתח ולהציע דרכים למניעת כשלים במערכות קיימות או כאלה שנמצאות בתהליכי תכנון. שיטת AFD נוקטת בגישה "התקפית" פרו-אקטיבית המנסה להמציא ולפתור תקלות יש מאין, בניגוד לגישה הפאסיבית שעל-פיה מעריכים בעזרת כלים סטטיסטיים את ההסתברויות לתקלות שעלולות להתרחש במערכת. הטקטיקה ההתקפית נוסחה כבר במאה השישית לפני הספירה על-ידי האסטרטג הסיני סון טסו (מחבר הספר "אומנות המלחמה"). מבחינה פסיכולוגית הגישה התקיפה מעוררת לפעולה בעוד לגישה המתגוננת והפאסיבית יש יסודות משתקים. לכן שיטת AFD (שאחד מלקוחותי קרא לה "שיטת החבלה") מבטיחה תוצאות יעילות ואפקטיביות. אולם היתרון המשמעותי שלה הוא ביכולתה לייצר תרחישים רבים באופן שיטתי ובזמן קצר.

כיצד עובדת שיטת AFD

ראשית מנסחים את התופעה שאותה רוצים למנוע. לדוגמה, "תאונה הנגרמת בגלל עדכון תוכנה באוויר (OTA) בזמן שהרכב במצב נסיעה", או "תאונה הנגרמת בגלל שיבוש במערכת השליטה והבקרה של הרכב האוטונומי". בשלב הבא מנסחים את הבעיה בצורה הפוכה, כתופעה רצויה, כללית ככל האפשר ומועצמת ככל הניתן. למשל: "כיצד לגרום לכל עדכוני התוכנה להתבצע תמיד בזמן נסיעה על כל סוגי הרכב" , או "כיצד להטעות את מערכות השליטה והבקרה של כל הרכבים האוטונומיים מתוצרת חברת XXX", וכדומה.

שיטת AFD נתמכת בתוכנה המורכבת משני חלקים עיקריים: המערכת הגרפית Problem Formulator לבניית תרשימי סיבה ותוצאה המתארים את הבעיה, ומערכת מומחה לניסוח שיטתי של תרחישים לבעיה הנחקרת.

נדגים את הרעיון: נניח שאחד התרחישים המומצאים לבעיה שהוזכרה קודם (עדכון תוכנה בזמן נסיעה) יכול להתקיים בתנאי שסנסור X לא יתפקד. כעת יש להמציא תרחיש המשבש את פעולת הסנסור. המטרה תושג כאשר יימצא תרחיש אשר תנאי הקיום שלו מתקיימים במציאות (למשל סנסור X אינו מתפקד בזמן נסיעה לאחור או בזמן החלפת הילוך). הנחת העבודה היא שהתרחיש יתקיים בסבירות גבוהה ברגע שהתנאים יאפשרו זאת, ויגרום לעדכון תוכנה אשר ישבש את פעולת הרכב.

שיטת AFD מבוססת על חשיבה הפוכה: במקום למנוע את הבעיה, מנסים ליצור באופן יזום. בנוסף היא מובילה את החוקר באופן שיטתי ליצירת תרחישים רבים ומגוונים שלא ניתן היה להגיע אליהם בצורה אחרת. גישה זו מתאימה ליצירת תרחישים בלתי צפויים בתחום ההגנה על רכב אוטונומי, ובכך לשפר מאוד את אמינות ועמידות המערכות הקריטיות האלו.

ניתן ללמוד את השיטה ולרכוש את התוכנה המסייעת להריץ את השיטה בקישור זה.

פורסם בקטגוריות: אבטחת סייבר , בינה מלאכותית , חדשות , רכב אוטונומי