מיקרוסופט חשפה את מאיץ הבינה המלאכותית Maia 200

27 ינואר, 2026

מיוצר בתהליך 3 ננומטר של TSMC וכולל יותר מ-10 מיליארד טרנזיסטורים. מיועד להעניק לענן Azure יתרון תחרותי בעיקר מול אמזון וגוגל, בהרצת מודלי AI גדולים

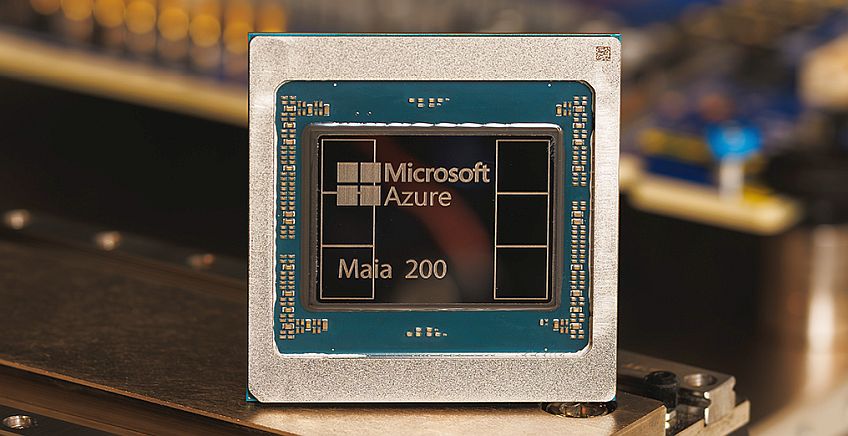

בתמונה למעלה: שבב Maia 200 של מיקרוסופט. קרדיט: מיקרוסופט

חברת מיקרוסופוט (Microsoft) הכריזה על שבב ההאצה Maia 200 עבור תשתיות בינה מלאכותית, אשר תוכנן ייעודית לשמש כמאיץ הסקות (inference) עבור מודלי AI הפועלים בזמן אמת. השבב כולל יותר מ-100 מיליארד טרנזיסטורים ומיוצר בתהליך 3 ננומטר של חברת TSMC. הוא כולל ליבות Tensor ייעודיות לפורמטים המספריים FP8 ו–FP4 המשמשים ברשתות עומר נוירוניות. הוא כולל זכרון פנימי מסוג HBM3e בנפח של 216GB המעביר מידע בקצב של 7Tbps, וזכרון SRAM בנפח של 272MB.

מיקרוסופט ביצעה את ההכרזה לאחר שהיא כבר החלה לפרוס אותו בשרתי Azure בארצות הברית, ובהמשך הוא יגיע לאתרי הענן של Azure באזורים נוספים בעולם. להערכת החברה, המאיץ החדש מספק ביצועי FP4 גבוהים פי שלושה מאלה Amazon Trainium דור שלישי, וביצועי FP8 טובים יותר בהשוואה למאיץ TPU מהדור ה-7 של גוגל. הוא מספק עוצמת עיבוד של כ-10petaFLOPS ברמת דיוק של 4 ביט (FP4), ויותר מ-5petaFLOPS ברמת דיוק של 8 ביט (FP8), במעטפת הספק של 750W.

פתיחת צווארי בקבוק

במסגרת הפיתוח, שיפרה מיקרוסופט את תהליך הזנת הנתונים, המהווה גם הוא צוואר בקבוק בהפעלת מודלים גדולים. לצורך זה תוכננו מחדש מנוע העברת נתונים בין הזכרון למעבד (Direct Memory Access) ורשת תקשורת פנימית בתוך השבב (NoC), ושולב זכרון ה-SRAM כחלק בלתי נפרד מאריח הסיליקון. פירוש הדבר שהמאיץ יכול לשמור חלק גדול ממשקלי המודל והנתונים קרוב לחישוב עצמו, ובכך להפחית את הצורך להעבירם בין ההתקנים השונים.

במקביל להכרזה, מיקרוסופט השיקה גירסה ראשונה של ערכת הפיתוח Maia SDK, שנועדה לסייע למפתחים לבצע אופטימיזציה של הקוד הקיים והתאמתו ל–Maia 200. הערכה כוללת תוכנה אינטגרטיבית ומודל תכנות מרחבי, המעניקים למשתמשים יכולת שליטה מדויקת ברמה החומרה של המאיץ.

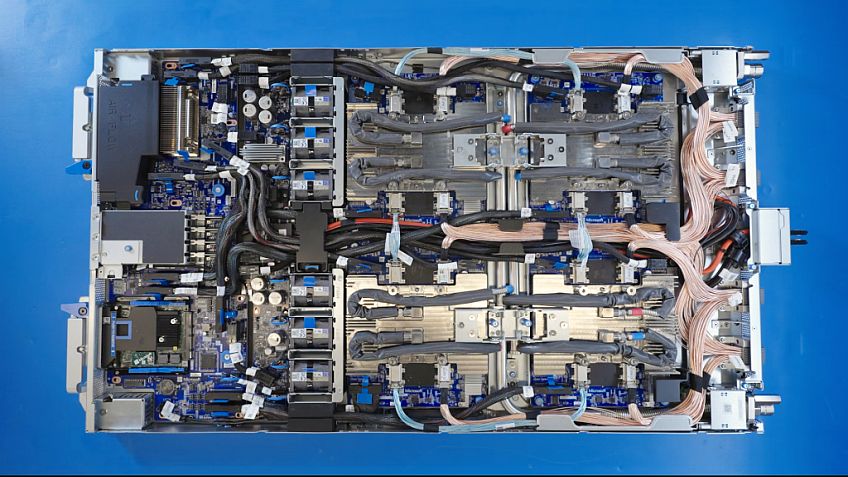

בתמונה: Maia 200 server blade של מיקרוסופט

פיתוח בגישה מערכתית

חברת מיקרוסופט דיווחה שהיא ביצעה את הפרוייקט במסגרת תהליך שכלל פיתוח פתרון מלא, שמאיץ הסיליקון הוא רק מרכיב אחד ממנו. היא החלה בפיתוח מערכת שלמה וביצעה אימות של האופן שבו החומרה, התוכנה והרשת יעבדו ביחד. החל משלבי הפיתוח הראשונים של Maia 200, נעשה שימוש מאסיבי בסימולציות המדמות את דפוסי החישוב והתקשורת של מודלי שפה גדולים. הדבר סייע לייעל במקביל גם את תכנון השבב וגם את מערך התקשורת ותוכנת המערכת, עוד לפני שהשבב יוצר בפועל.

במקביל, מיקרוסופט פיתחה סביבת אמולציה רחבת היקף המאפשרת להריץ מודלי AI אמיתיים, לכייל ביצועים ולבדוק עומסים על תשתית המדמה באופן נאמן את החומרה העתידית. מאיץ Maia 200 תוכנן מראש למרכזי הנתונים של Azure, וכולל תאימות מלאה למערכות הניהול של Azure המבצעות ניטור, אבטחה וניהול רציף ברמת השבב וברמת התשתית כולה.

קודם צוותי מיקרוסופט, אחר-כך הלקוחות

המשתמשים הראשונים בשבב החדש יהיו צוותי Microsoft Intelligence, שיפעילו את המאיץ לצורך יצירת נתונים סינתטיים ולמידה, במסגרת פיתוח הדור הבא של מודלי AI הפנימיים של מיקרוסופט. בהמשך, ישולב Maia 200 ישולב גם בהפעלת עומסי AI של Microsoft Foundry ושל Microsoft 365 Copilot, כחלק מתשתית ה–AI של מיקרוסופט בענן הגלובלי. מיקרוסופט הודיעה שלאחר מכן צפויה פתיחה הדרגתית של היכולת הזו גם ללקוחות.

פורסם בקטגוריות: בינה מלאכותית , חדשות , מחשבים ומערכות משובצות , סמיקונדקטורס

פורסם בתגיות: Maia 200 , בינה מלאכותית , מאיץ , מיקרוסופט , שבבים