פלטפורמת Rubin מדיחה את ה-GPU ממעמדו המורם

6 ינואר, 2026

במקום מאיץ יחיד שמוביל את המערכת, אנבידיה מחלקת מחדש את תפקידי ה-GPU, ה-CPU, הזיכרון והקישוריות, כדי לבנות תשתית המותאמת לעולם של הסקות וסוכני AI מרובים

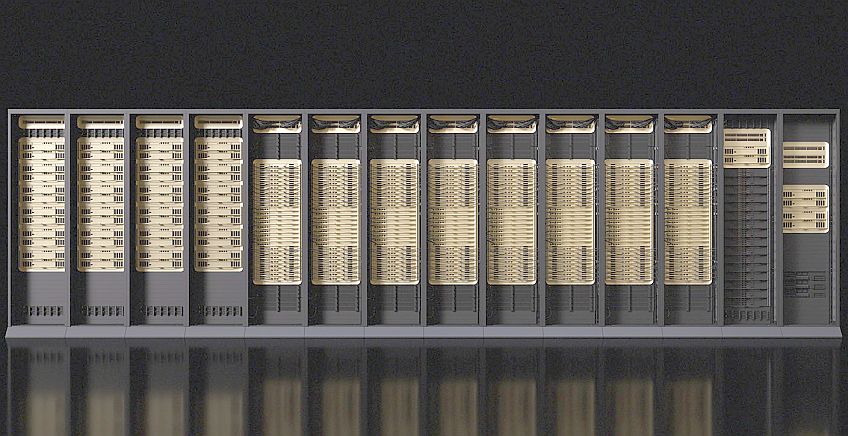

בתמונה למעלה: פלטפורמת רובין המלאה. מקור: אנבידיה

חברת אנבידיה (NVIDIA) חשפה בתערוכת CES 2026 בלאס וגאס את פלטפורמת Rubin, שאותה היא מגדירה "הדור הבא של תשתיות בינה מלאכותית". עצם קיומה של Rubin והעובדה שתגיע לשוק במחצית השנייה של 2026 כבר היו ידועות. אלא שבהכרזה הנוכחית נחשף לראשונה הרעיון העומד מאחוריה: לא עוד דור של מעבדים גרפיים, אלא שינוי תפיסתי עמוק באופן שבו נבנות ומופעלות מערכות AI בקנה מידה גדול. במקום רכיב GPU גדול העומד במרכז ומקבל תמיכה ממערכות אחרות – אנבידיה הציגה ארכיטקטורה שלמה הפועלת כיחידה אחת באמצעות שילוב של חישוב, זיכרון, רשת ואבטחה.

המסר החוזר הוא שרובין איננה שבב אלא מערכת מחשוב שלמה בקנה מידה של ארון שרתים. היא מיועדת לסביבה שבה הבינה מלאכותית אינה צ’אטבוט בודד או משימה חד־פעמי, אלא סביבה מרובת-סוכנים הפועלים לאורך זמן, שומרים הקשר, משתפים זיכרון ומסיקים מסקנות בסביבה משתנה. במובן הזה, Rubin מסמנת מעבר של אנבידיה משיווק של עוצמת חישוב לשיווק של תשתית קוגניטיבית.

Extreme Codesign כעיקרון

אנבידיה משתמשת כבר שנים במונח full stack, אך ברוב המקרים המשמעות הייתה ערימה של רכיבים שנבנו סביב ה־GPU. בהקשר של Rubin היא הגדירה מחדש המונח Codesign. מסורתית, המונח הזה מתייחס לחתימה דיגיטלית על קוד תוכנה. אנבידיה מתארת את הגישה שלה כ-Extreme Codesign ומתכוונת לדבר שונה לחלוטין: תכנון משותף מראש של כל חלקי המערכת במטרה להביא אותם לפעול כיחידה אחת המותאמת לעומסי עבודה גדולים מאוד.

אחת המשמעויות של Extreme Codesign היא שה־GPU הפסיק להיות נקודת המוצא של הארכיטקטורה. אומנם הוא רכיב מרכזי חשוב, אולם איבד את מעמדו כלב המערכת. התכנון של Rubin מבוסס על ההנחה שצוואר הבקבוק (bottleneck) של מערכות ה-AI אינו בכוח החישוב הגולמי, אלא ביעילות המערכתית הכוללת: ניהול הקשר, זיכרון מתמשך ותזמון בין תהליכים וסוכנים. בעיות כאלה אינן ניתנות לפתרון באמצעות מעבד GPU חזק יותר, אלא באמצעות חלוקה מחדש של תפקידים בין רכיבי המערכת. מדובר בנקודת מפנה עבור אנבידיה. היא נוטשת את תפיסת GPU-first שאפיינה אותה מאז ימי CUDA, ומאמצת תפיסה מערכתית שבה החישוב הוא רק מרכיב אחד של המערכת.

תפקידו החדש של ה־CPU

מערכת Rubin כוללת את המעבד Vera CPU של אנבידיה. בניגוד ל-CPU מסורתי במרכזי AI שתפקידו בעיקר לארח ולתזמן את עבודת ה-GPU, כאן מדובר במעבד שתוכנן מראש כחלק אינטגרלי של מערך ההסקה והחשיבה אשר תפקידו המרכזי הוא לתאם בין סוכנים, לנהל זרימות עבודה מרובות שלבים ולהפעיל לוגיקה שאינה מתאימה לביצוע ב-GPU. ייתכן שמדובר שינוי עמוק בתפקידי ה־CPU בעידן ה-AI. הוא חוזר להיות רכיב חישובי משמעותי הפועל בסימביוזה עם המאיץ הגרפי ולא מעליו או מתחתיו. הדבר מלמד שאנבידיה שואפת לשלוט גם בשכבת התזמור והשליטה, ולא רק בחישוב עצמו.

הבחירה בארכיטקטורת Arm עבור המעבד Vera משקפת את הצורך של אנבידיה לשלוט במבנה ה־CPU עצמו. בניגוד למעבדים כלליים שמיועדים להריץ מגוון רחב של עומסי עבודה, Arm מאפשרת לאנבידיה לעצב מעבד המותאם בדיוק למשימה, תוך ויתור על שכבות לוגיקה שאינן רלוונטיות להסקה ולתזמור סוכנים. כלומר מודל מרכזי הנתונים הקלאסי, המבוסס על CPU בארכיטקטורת x86 כנקודת מוצא, אינו עוד הבחירה המובנת מאליה במערכות שנבנות מראש כ־AI-first.

זיכרון, אחסון והולדת שכבת ההקשר

ככל הנראההחידוש הארכיטקטוני המשמעותי ביותר בהכרזה הנוכחית נוגע לאופן שבו מנוהל הזיכרון של תהליכי inference. אנבידיה מציגה גישה חדשה לניהול זיכרון ההקשר של מודלים גדולים, ובפרט של KV Cache הנוצר במהלך הסקה מרובת שלבים. בארכיטקטורה הקלאסית, שתוכננה סביב עומסי עבודה קצרים ומבודדים, זיכרון כזה נדרש להישאר ב-HBM של ה־GPU כדי לשמור על ביצועים, מה שהפך אותו למשאב יקר ומוגבל והקשה על עבודה מתמשכת ורב־סוכנית.

ב־Rubin הועבר חלק ניכר מזיכרון ההקשר אל מחוץ ל-GPU, לשכבה ייעודית המתנהגת כמו זיכרון ולא כמו אחסון מסורתי. כאן משתנה גם תפקידו של BlueField-4, שהוא מעבד DPU שמקורו בטכנולוגיית הרשת של מלאנוקס. הוא כרכיב להסטת עומסים (offload) והופך לחלק פעיל בניהול זיכרון ההקשר ובתיאום הגישה אליו. השינוי הזה נובע מהפער בין ארכיטקטורות שנבנו עבור אימון או inference חד-פעמי, לבין הצרכים של מערכות סוכנים שפועלות לאורך זמן, שומרות מצב ומשתפות הקשר בין רכיבים. ניהול הזיכרון הפך לחלק מנתיב הביצועים של inference, ולא לשכבת I/O חיצונית.

קישוריות כרכיב חישובי ומעבר לעולם הסוכנים

גם תחום הקישוריות משנה את ייעודו ב-Rubin. ה-NVLink ממשיך לשמש כחיבור פנימי מהיר בין GPUs, אך שכבת ה־Ethernet, בדמות Spectrum-6 ו-Spectrum-X, מקבלת תפקיד שונה מזה שהייתה לה במרכזי נתונים מסורתיים. במקום לשמש רק להעברת נתונים בין שרתים, הרשת הופכת לחלק מהאופן שבו המערכת כולה מנהלת חישוב וזיכרון. הקישוריות מאפשרת לרכיבים השונים (GPUs, מעבדים ויחידות DPU) לגשת לזיכרון משותף, לשתף מצב בין תהליכים, ולפעול כאילו היו חלק ממערכת אחת רציפה, גם כשהם מותקנים בשרתים או מסדים נפרדים. טכנולוגיות כמו RDMA (גישה ישירה לזיכרון דרך הרשת) מאפשרות גישה ישירה לזיכרון דרך הרשת, ללא מעורבות ה־CPU. כלומר הרשת אינה רק מעבירה נתונים אלא משתתפת בפועל בזרימת ההסקה.

למעשה המערכת מעבירה את הדגש מאימון כמרכז הכובד, להסקה מתמשכת ומרובת סוכנים. Rubin מיועדת לעולם שבו רוב עלות ה־AI והערך העסקי שלו נמצאים בשלב ההפעלה ולא בשלב האימון. בעולם כזה, מה שקובע הוא לא רק כמה מהר ניתן לחשב, אלא כמה טוב ניתן לזכור, לשתף ולהגיב. זהו ניסיון מעניין של אנבידיה להגדיר מחדש את מבנה תשתיות ה-AI. לא עוד מרוץ אחר TFLOPS, אלא תחרות על מי שולט בארכיטקטורה כולה. אם המהלך יצליח, אנבידיה לא תהיה רק ספקית של מאיצים, אלא ספקית של תשתית מחשבתית מלאה.

פורסם בקטגוריות: בינה מלאכותית , חדשות , מחשבים ומערכות משובצות , סמיקונדקטורס

פורסם בתגיות: Rubin , אנבידיה , בינה מלאכותית , מעבדים