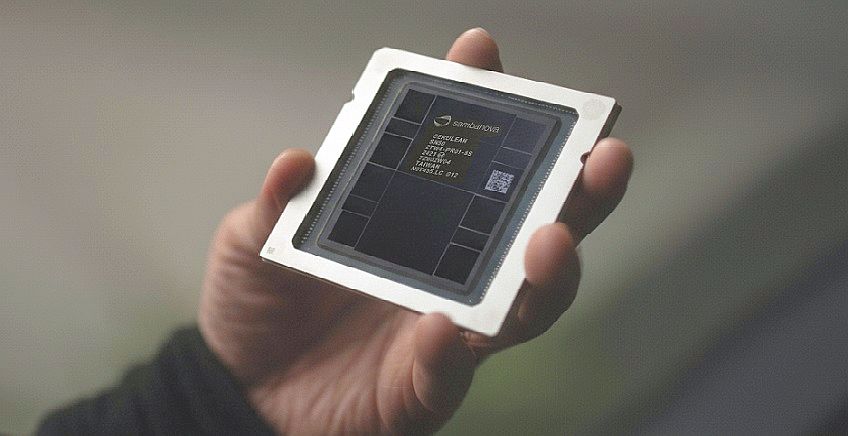

בתמונה למעלה: שבב SN50 של סמבנובה. מקור: SambaNova

חברת אינטל הצטרפה לגיוס ההון החמישי של חברת סמבה-נובה (SambaNova Systems) מפאלו אלטו, קליפורניה, אשר הושלם בהובלת Vista ו-Cambium והגיע להיקף כולל של כ-350 מיליון דולר. ההשקעה של אינטל בוצעה באמצעות זרוע ההשקעות המרכזית שלה, Intel Capital. ביחד עם השלמת הגיוס, הכריזה סמבה-נובה על שבב ההסקות מהדור החמישי שלה, SN50, ועל שיתוף פעולה אסטרטגי ארוך-טווח עם חברת אינטל בפיתוח ואספקת פתרונות הסקת בינה מלאכותית (AI Inference) עתירי ביצועים. שיתוף הפעולה יתבסס על שילוב מעבדי Xeon של אינטל ביחד עם שבבי Reconfigurable DataFlow Units – RDU, ליצירת פתרון חומרה ותוכנה מלא ליישומי AI מבוססי סוכנים (Agentic AI).

המהלך המשותף מיועד לספק חלופה לפתרונות מבוססי מעבדים גרפיים (GPU-centric) שהמתחרה אנבידיה מובילה. במקביל לפיתוח ופריסת המערכות החדשות, אינטל הודיעה שהיא מתכננת לבצע השקעה אסטרטגית ב-SambaNova כדי להאיץ את הפריסה של ענני AI מבוססי טכנולוגיות אינטל. שתי החברות מסרו ששיתוף הפעולה יתמקד בשלושה תחומים מרכזיים: הרחבת שירות הענן של סמבה-נובה המבוסס על הטכנולוגיה שלה; פיתוח תשתית AI משולבת הכוללת את המערכות, התוכנות והשבבים של SambaNova ביחד עם המעבדים, המאיצים וטכנולוגיות הרשת של אינטל; ושיתוף פעולה בשיווק ומכירות באמצעות ערוצי המכירה הגלובליים של אינטל לארגונים ולשותפים עסקיים.

מאיץ ייעודי לסוכני AI

חברת SambaNova הוקמה בשנת 2017 בקליפורניה על-ידי צוות חוקרים ומהנדסים מאוניברסיטת סטאנפורד, ובהם רודריגו ליאנג, קונלה אולוקוטון וכריסטופר רה. מאז הקמתה היא גייסה יותר ממיליארד דולר ממשקיעים, ובחלק מהסבבים הגיעה להערכת שווי שוק של יותר מ-5 מיליארד דולר. החברה פיתחה את ארכיטקטורת RDU במטרה להתגבר על בעייה ספציפית. להערכת החברה הבעיה המרכזית כיום במעבדי הסקה היא לא עוצמת העיבוד, אלא קצב העברת המידע בתוך המעבד. ביישומים מבוססי סוכנים, הבעיה מחמירה, מכיוון שלא ניתן לדעת מתי ואיזה יישום יזדקקו להאיץ את קצב העברת המידע. הארכיטקטורה החדשה מבוססת על עקרון של העברת נתונים מהירה וגמישה, המאפשרת להאיץ את התפוקה הכוללת של עיבוד מרובה סוכנים. להערכת החברה, הפתרון שלה מהיר פי חמישה מכל פתרון אחר הקיים היום בשוק.

בתחילה החברה גיבשה אסטרטגיית מוצר: היא פיתחה מסדי שרתים המהווים פתרון שלם הכולל חומרה, תוכנה ושבבים פרי פיתוחה, שאותם מכרה ללקוחות. הדבר מעניק להם יכולת עיבוד במתכונת של On-prem. כלומר, השרתים יושבים בתוך החברה והיא לא צריכה להוציא את המידע לענן חיצוני, דוגמת OpenAI, Google או אחרים. לאחרונה החברה הגמישה את המודל העסקי והחלה גם בהקמת הענן SambaNova Cloud, אשר מספק שירותי עיבוד במתכונת של Inference as a Service. כלומר, החברה גובה תשלום על-פי תוכניות מנויים או לפי מספר הטוקנים שהלקוחות משתמשים בהם בענן שלה.

התוכנית לבלימת אנבידיה

שיתוף הפעולה האסטרטגי מהווה גם מענה עקיף לשיתופי הפעולה שמובילה אנבידיה אשר מיועדים לקדם את השימוש בתשתיות מבוססות GPU מקצה לקצה, ואף משתפת פעולה עם חברות דוגמת Groq באקוסיסטם הענן שלה. במודל של אנבידיה המאיץ (GPU או שבב ייעודי) הוא לב המערכת, כאשר ה-CPU משמש בעיקר כרכיב מארח ותומך. הדטה סנטר נבנה סביב המאיץ והתקשורת בין מאיצים, כאשר והתוכנות ממוקדות באופטימיזציה של החומרה הזו.

האסטרטגיה של אינטל הפוכה: שיתוף הפעולה עם סמבה-נובה מאפשר לה לספק תשתית הטרוגנית מהירה שבה מעבדי ה-Xeon שומרים על מעמדם בשכבת השליטה והניהול המרכזית. המאיץ – במקרה הזה SN50 – הוא רכיב ייעודי להרצת המודלים עצמם, כאשר עומק והיקף פעילותם מנוהל על-ידי המעבד בהתאם לסוג העומס. במקביל, אינטל ממשיכה לקדם יוזמות AI פנימיות, כולל פיתוח GPU למרכזי נתונים והשקעה בארכיטקטורות האצה.

האם ההשקעה ב-SambaNova משקפת גידור סיכונים מול התחרות ב-GPU, או הכרה בכך שעומסי הסקה – ובפרט Agentic AI – דורשים גישה ארכיטקטונית שונה? אינטל הבהירה בהודעתה ששיתוף הפעולה “אינו משנה את מפת הדרכים של החברה בתחום ה-GPU ואינו פוגע במחוייבותה להתחרות בשוק ה-AI”, אלא מהווה הרחבה של היצע הפתרונות של החברה. כך או אחרת, המהלך ממקם את אינטל מחדש כשחקנית מרכזית שתשפיע על עתיד תשתיות הבינה המלאכותית.