הרגולטור חייב להתמודד עם בעיית הבינה המלאכותית

22 מרץ, 2023

אם החוק לא יסדיר את המותר והאסור בתחום הבינה המלאכותית - בדומה לנעשה בשוק הרכב ובשוק הבריאות - אנחנו צפויים לעמוד בפני משבר חברתי חסר-תקדים ובעל השלכות הרות-אסון

בתמונה למעלה: דמות סינתטית מתוך הסרט Avatar: The Way of Water, קרדיט: 20th Century Studios

מאמר דעה. מאת: רוני ליפשיץ, עורך Techtime

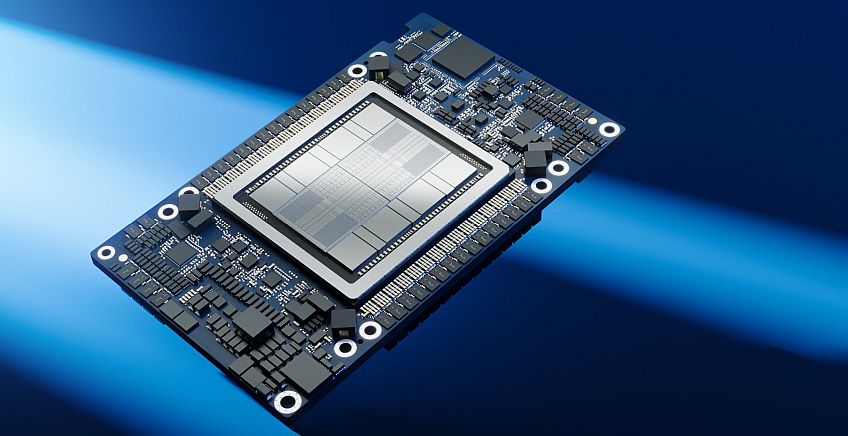

השבוע השיקה חברת אנבידיה שירות חדש בשם DGX Cloud, המאפשר לחברות לאמן רשתות בינה מלאכותית באמצעות הענן. השירות יהיה נגיש ללקוחות באמצעות ענני-ענק דוגמת אורקל, אמזון, גוגל ואז'ור של מיקרוסופט. אנבידיה תספק באמצעותו את כל תשתיות החומרה והתוכנה המאפשרות לחברות לפתח יישומי בינה מלאכותית ולאמן רשתות נוירוניות גדולות, כולל גישה אל חבילה של תוכנות מקטגוריית Generative AI, אשר מסוגלות לייצר אובייקטים דיגיטליים חדשים על בסיס בקשות טקסטואליות.

שירות NeMo למשל, מאפשר לייצר תכנים באמצעות מודלים של שפות שבאמצעותם ניתן לייצר בוטים המתנהגים כבני אדם. שירות Picasso מייצר אובייטים ויזואליים חדשים כמו תמונות, דגמים תלת מימדיים וסרטי וידאו, באמצעות בקשות טקסטואליות. הפוטנציאל הטמון בטכנולוגיות האלה הוא עצום: ראו למשל את האפקט של פתיחת ממשק ציבורי לשירות ChatGPT. המהלך היה כל-כך מרשים שלאחרונה אמר אחד ממנהלי חברת התוכנה דאסו סיסטמס, ש"בינואר 2022 העולם השתנה".

אלא שיש מכנה משותף אחד בכל החידושים האלה: למשתמש אין שליטה מלאה במודלים ובבסיסי המידע שמאחוריהם, ולצרכני המוצרים אין יכולת לדעת האם סרטון הווידאו, התמונה, או הדובר שמאחורי הטלפון – הם אמיתייים או סינתטיים. ומכיוון שכל מקורות המידע שלנו הם כיום דיגיטליים, ההתקדמות המואצת של תחום הבינה המלאכותית מביאה אותנו במהירות אל מצב שבו לא נוכל להבדיל בין אובייקטים אמיתיים לבין אובייקטים מלאכותיים. או במלים אחרות – להבדיל בין אמת לשקר.

הנה דוגמא קטנה: לאחרונה הציגה חברת תוכנה גדולה תכונה חדשה בשיחות וידאו מקוונות: יישום הלומד את מאפייני המשתתפים בשיחה, ומוודא שהם ייראו כאילו הם תמיד מרוכזים, ולא מורידים את מבטם מהמסך. כלומר, הוא מייצר מצג מעורב, שבו תוכנת בינה מלאכותית מתקנת את המציאות בכל רגע. נגיעות קלות, אבל משמעותיות. התוצאה: למשתתף בשיחה אין אפשרות לדעת האם ההקשבה של עמיתו מבטאת הקשבה אמיתית – או שהיא "תיקון סינתטי" של סוכן תוכנה.

האם נידרש לרישיון שימוש בבינה מלאכותית?

מכאן שעוד לפני שנכנסנו לבעיות קשות של שמירת קניין רוחני, עמידה בדרישות איכות ובטיחות או בקרה על איכות ואמינות המודלים הגנרטיביים ובסיסי הנתונים שלהם, אנחנו כבר מצויים בעולם שבו הבינה המלאכותית משבשת את תפישת המציאות שלנו. זהו רגע קריטי המחייב התערבות רגולטורית מיידית. כפי שהרגולטורים מכתיבים נורמות התנהגות בתחומים כמו שמירה על פרטיות ברשת, מדיניות אבטחת מידע מוגדרת, מניעת קרינה אלקטרומגנטית מסוכנת ונכנסים לתחומים רבים שבהם הטכנולוגיה עשויה לסכן את החברה או את בני האדם כפרטים – הגיע הזמן שהם יתמודדו עם גם אתגר הבינה המלאכותית.

אם הם לא יעשו כן, יש סיכוי שבעתיד הקרוב נתגעגע לסוגיות פשוטות כמו "פייק ניוז". גם אם הדבר כרוך בהאטה טכנולוגית מסויימת, הרגולטור צריך להיכנס מיידית לתמונה ולהתחיל להגדיר מה מותר ומה אסור. ההתנהלות הזאת מוכרת ומקובלת בתחומים רבים, כמו למשל תחבורה, מערכות בריאות, בקרת מזון ותרופות ועוד. התעשייה מכבדת את הצורך של הרגולטור להגן על החברה ולהבטיח מערכות אמינות ובטוחות. היא למדה לחיות עם הליכי אישור ארוכים אך חיוניים, ואפילו מפיקה מכך תועלת.

הגיע הזמן להסדיר את תחום הבינה המלאכותית: להגדיר מה הן הדרישות מהקוד כדי להבטיח שיעמוד במטרותיו, להבטיח הפרדה בולטת וחד-משמעית בין מידע סינטתי למידע מקורי, לחייב שימוש רק במודלים ובבסיסי נתונים שקיבלו הסמכת אמינות ובטיחות, כדי להבטיח את איכותם ואמיתיותם. להגדיר את האסור והמותר בתחום הזה, ולהתנות פעולות מסויימות בקבלת רישיון. ללא התמודדות עם הבעיה הזאת, אנחנו עשויים להגיע למשבר חברתי ותרבותי חסר תקדים ובעל השלכות הרות-אסון.

פורסם בקטגוריות: בינה מלאכותית , חדשות , טכנולוגיות מידע

פורסם בתגיות: בינה מלאכותית