מאת: יוחאי שויגר

אומנם הכרזת פלטפורמת Rubin של אנבידיה לתשתיות בינה מלאכותית משכה את רוב תשומת הלב בכנס CES 2026 שהתקיים בשבוע שעבר בלאס וגאס, אולם היא ביצעה בכנס מהלך נוסף, מעט בצנעה, שיש לו משמעות אסטרטגית עמוקה על שוק הרכב: השקת המודל הפתוח לנהיגה אוטונומית Alpamayo, שנועד לשמש כשכבת תכנון והחלטה במערכות נהיגה עתידיות. ההשקה צפויה להשפיע גם על האופן שבו יפותחו מערכות נהיגה אוטונומית, וגם על מערך היחסים שבין ספקי הטכנולוגיה בשוק הרכב, ובמיוחד על חברות האוטוטק הישראליות.

רוב החברות הישראליות, דוגמת אינוויז וארבה המפתחות חיישני LiDAR ומכ"ם, או קוגנטה ופורטיליקס הפועלות בתחומי הסימולציה והאימות של מערכות נהיגה, אינן מספקות מערכת שלמה אלא רכיבי ליבה בתוך שרשרת הערך. עבורן זה עשוי להתברר כמהלך תומך. מנגד, קיומו של מודל תכנון פתוח וגמיש המאפשר ליצרניות רכב להרכיב מערך תוכה-חומרה (Stack) המותאם לפלטפורמת מחשוב אחת מציב אתגר אסטרטגי בפני מובילאיי. החברה מירושלים בנתה את מעמדה על פתרון מלא מקצה לקצה, ועל נטילת אחריות מערכתית מלאה.

NVIDIA DRIVE: אקוסיסטם AI-First לשוק הרכב

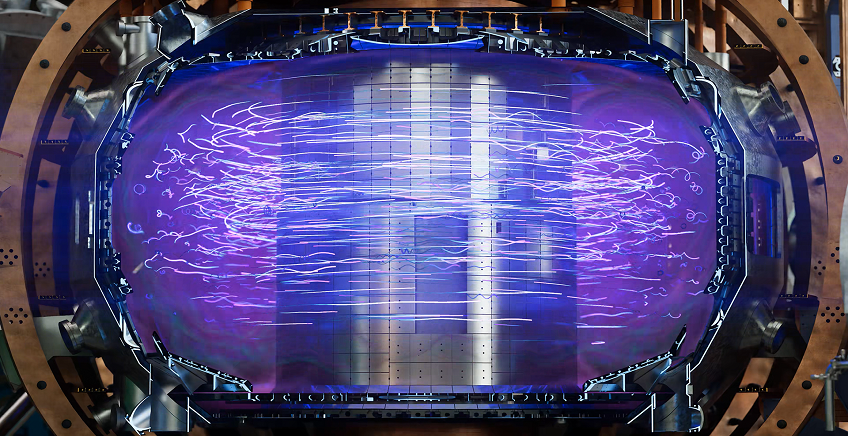

מודל Alpamayo מצטרף לשורת הפתרונות שאנבידיה מאגדת תחת פלטפורמת NVIDIA DRIVE, שהיא מערך רחב היקף לפיתוח מערכות רכב חכמות. הפלטפורמה כוללת משפחות מעבדים ייעודיים כמו Orin ו-Thor, מערכת הפעלה לרכב, כלים לעיבוד ואיחוד נתוני חיישנים, סימולציות מבוססות Omniverse ו-DRIVE Sim ותשתיות אימון וניהול מודלים בענן. במילים אחרות, מדובר בסטאק מלא המיועד ללוות את יצרניות הרכב משלב הפיתוח והבדיקות ועד להרצה בזמן אמת ברכב עצמו.

המודל משתלב בתפיסת AI-first vehicle stack שהחברה מקדמת: מעבר ממערכות הנשענות בעיקר על חוקים ידניים ואלגוריתמים ייעודיים, למערכות שבהן מודלי בינה מלאכותית גדולים הופכים לרכיב מרכזי. גם בשכבות שבעבר נחשבו כמתאימות לאלגוריתמים “קלאסיים”, כמו למשל שכבת קבלת ההחלטות. בהקשר הזה Alpamayo הוא רכיב אסטרטגי: לראשונה מציעה NVIDIA מודל foundation תוצרת בית לשכבת התכנון וההחלטה, המאחד את NVIDIA DRIVE סביב רעיון הסטאק מבוסס AI מקצה לקצה – מהאימון בענן ועד הביצוע במחשב הרכב.

המוח הטקטי של הרכב

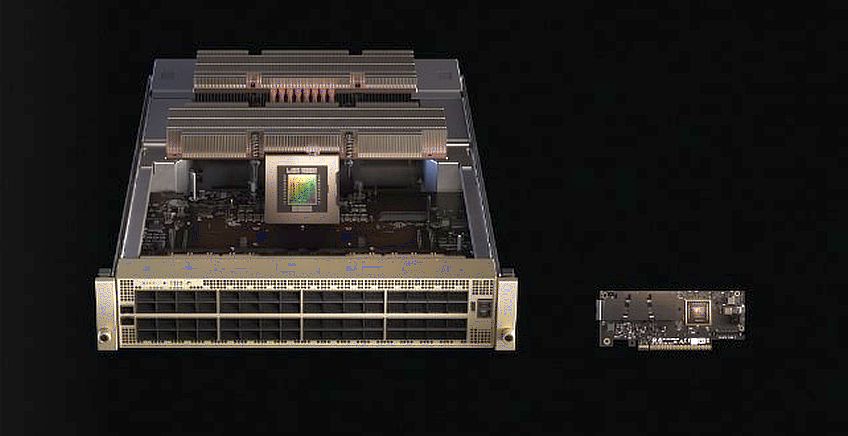

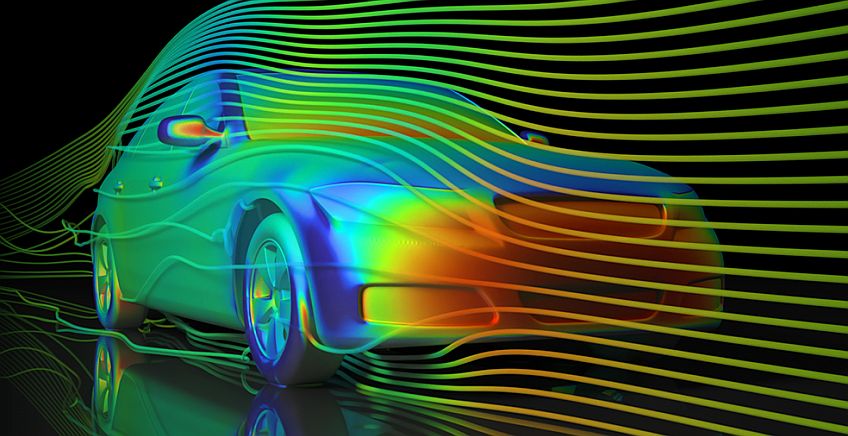

Alpamayo הוא מודל מולטי-מודלי גדול מסוג Vision-Language-Action (VLA), המקבל מידע ממספר מצלמות וידאו, חיישני LiDAR, חיישני מכ"ם ומערכות הרכב עצמן, ומתרגם את המידע לייצוג פנימי המאפשר לבצע הסקות ותכנון פעולה. על בסיס זה הוא מפיק מסלול תנועה עתידי לטווח של כמה שניות קדימה. המודל אינו מפעיל ישירות את מערכות הרכב כמו בלמים או הגה, אבל קובע מהי ההתנהגות הטקטית של הרכב.

בניגוד למודלי שפה כלליים, Alpamayo פועל במרחב פיזי ומשלב תפיסה עם reasoning מרחבי וקונטקסטואלי. הקלט שלו כולל רצפי וידאו, נתוני תנועה, ולעיתים גם מפות ויעדי ניווט. המודל מבצע הבנת סצנה, הסקת סיכונים ותכנון מסלול כחלק משרשרת החלטה אחת. הפלט המרכזי הוא trajectory: מסלול רציף שמועבר לשכבת הבקרה הקלאסית של הרכב, שאחראית על ההפעלה הפיזית והבטיחותית.

אימון מודל כזה מתבצע באמצעות שילוב של נתונים סינתטיים עם נתונים מהעולם האמיתי. הנתונים הסינתטיים מיוצרים באמצעות פלטפורמות הסימולציה של אנבידיה: Omniverse ו-DRIVE Sim. המודל משוחרר במתכונת קוד פתוח, כולל המשקלים וקוד האימון. הדבר מאפשר ליצרניות רכב ולספקי Tier-1 לאמן אותו על המידע שלהן, להתאים אותו לארכיטקטורת המערכת שלהם, ולשלב אותו במערכת הסטאקים שלה. לא כמוצר סגור, אלא כבסיס לפיתוח פנימי. אנבידיה גם דיווחה מספר שותפויות עם חברות מובילות, בהן: Lucid Motors,Jaguar Land Rover, Uber ושת"פ עם עם גופים Berkeley DeepDrive בפיתוח טכנולוגיות נהיגה אוטונומית מתקדמות.

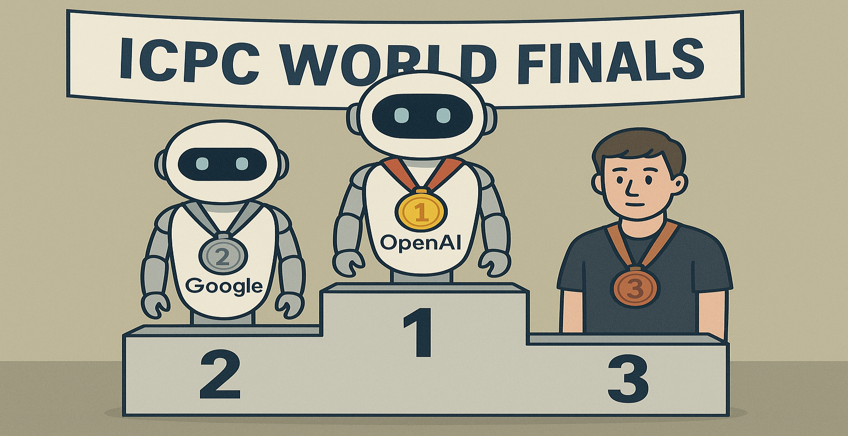

מובילאיי: אתגר לפתרון המלא

סטאק נהיגה אוטונומית בנוי מכמה שכבות: חיישנים, תפיסה (perception), תכנון והחלטה (planning), ובקרה (control). Alpamayo יושב בשכבת התכנון. הוא אינו מחליף את התפיסה, ואינו מחליף את שכבות הבטיחות והשליטה, אך הוא מחליף (או לפחות מאתגר) את שכבת קבלת ההחלטות האלגוריתמית הקלאסית. המשמעות היא שהמערכת יכולה להיות מודולרית: תפיסה מספק אחד, תכנון ממודל של אנבידיה, בקרה מ-Tier-1 אחר. זהו שינוי תפיסתי לעומת פתרונות “קופסה שחורה” מקצה לקצה.

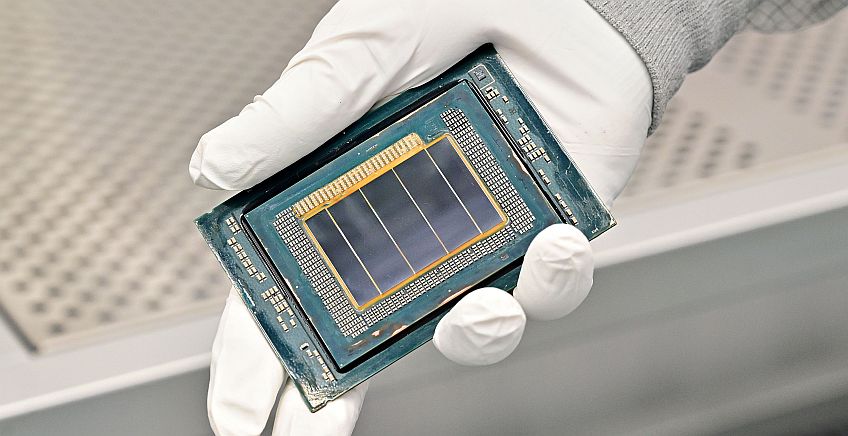

כאן מגיעה נקודת המתח מול מובילאיי. במשך שנים מובילאיי בנתה הצעת ערך של סטאק כמעט מלא: חיישנים, תפיסה, מיפוי, תכנון, ושבבי EyeQ ייעודיים המריצים את כל הפתרון ביעילות אנרגטית גבוהה. זה מודל שמתאים מאוד ל-ADAS ול-L2+, וגם לגרסאות מתקדמות יותר של אוטונומיה. אך מודלי ייסוד לשכבת התכנון משנים את נקודת האיזון. הם דורשים חישוב גמיש ועוצמתי יותר מזה ששבבי ADAS ייעודיים מספקים, ודוחפים את המערכת לכיוון מחשוב מבוסס GPU.

אף שבתרחישים מסוימים ניתן לשלב רכיבי תפיסה של מובילאיי בתוך סטאקים רחבים יותר, מרבית פתרונות האוטונומיה המתקדמים של החברה מוצעים כיחידה מערכתית שלמה, ולכן בפועל הגמישות להחלפת שכבות בודדות מוגבלת. מעבר לכך, עצם קיומו של מודל תכנון פתוח בשכבה הזו, מחליש את הערך של מודולי תוכנה קנייניים. במקום לפתח או לרכוש אלגוריתמי planning ייעודיים, ניתן להתאים מודל foundation קיים לדאטה ולצרכים הספציפיים של היצרן.

אין מדובר באיום מיידי על עסקי הליבה של מובילאיי, אך בטווח הארוך התמונה משתנה: ככל שהשוק ינוע לעבר L3 ול-L4, ושכבת ההחלטה תהפוך עתירת AI, המודל יהיה אתגר אסטרטגי אמיתי לרעיון הפתרון הסגור מקצה לקצה. ראוי לציין שיש למובילאיי נותר יתרון מבני משמעותי: היא מספקת פתרון מקצה לקצה ולוקחת אחריות מערכתית מלאה על תפקוד ובטיחות המערכת. עבור יצרניות רכב רבות, במיוחד כאלה שאינן מחזיקות יכולות תוכנה ו-AI עמוקות, זהו יתרון קריטי. הן מעדיפות ספק אחד הנושא באחריות על המערכת כולה, אשר פותר אותן מהצורך להרכיב ולתחזק “פאזל” של רכיבים מספקים שונים, עם אחריות מפוצלת וסיכונים רגולטוריים גבוהים.

החושים של אינוויז וארבה מקבלים חיזוק

בניגוד למובילאיי, עבור חברות ישראליות המספקות חיישנים כמו אינוויז (Innoviz) וארבה (Arbe), המהלך הזה עשוי להיות מבורך. מודלי תכנון מתקדמים נהנים מ-input עשיר, אמין ורב-חושי. LiDAR מספק מידע תלת-ממדי מדויק על מרחקים וגאומטריה, בעוד שהמכ"ם מצטיין בזיהוי עצמים בתנאי תאורה קשים ומזג אוויר מאתגר. המידע המגיע מהחיישנים האלה הוא קריטי עבור שכבות תכנון ומודלי קבלת החלטות המתכננים מסלולי נסיעה במרחב פיזי משתנה. לכן שתיהן ממצבות את עצמן כחלק מהאקוסיסטם של אנבידיה, ולא כאלטרנטיבה לו. הן אף הדגימו בפועל אינטגרציה של מערכות החישה והתפיסה שלהן עם פלטפורמות המחשוב DRIVE AGX Orin. הן מבינות שבסטאק שבו שכבת ההחלטה נעשית יותר מתוחכמת ועתירת חישוב, הערך של חיישנים איכותיים גדל. המודל יכול להיות חכם ככל שיהיה, אך אם הקלט מוגבל, ההחלטות יהיו גרועות.

קוגנטה ופורטליקס: מי יבדוק את בטיחות ה-AI?

כאן נכנסות לתמונה החברות הישראליות קוגנטה (Cognata) ופורטליקס (Foretellix), אשר מספקות למערכת את הסימולציה, האימות וההסמכה. קוגנטה מתמקדת ביצירת עולמות מדומים ובבניית תרחישי נהיגה מורכבים לאימון ולבדיקות, ופורטליקס מתמקדת בכלי verification & validation שמודדים כיסוי תרחישים, מזהים פערים בהתנהגות המערכת, ומספקים מדדים כמותיים לרגולציה ולמהנדסי בטיחות.

ככל שגדל משקלם של מודלי AI בסטאק הנהיגה, גובר הצורך בהוכחת אמינות ובטיחות מבוססת תרחישים, ולא רק בקילומטרים מצטברים על הכביש. לכן גם קוגנטה וגם פורטליקס פועלות בתוך האקוסיסטם של אנבידיה: קוגנטה משתלבת בסביבות הסימולציה וה-Hardware in the Loop (בדיקות עם חיבור ישיר לחומרת הרכב האמיתית) של DRIVE לצורך אימון ובדיקות בקנה מידה גדול, ופורטליקס מחברת את כלי האימות והוולידציה שלה לפלטפורמות Omniverse ו-DRIVE לצורך בדיקות בטיחות למערכות נהיגה מבוססות AI.

קוד פתוח, אבל פלטפורמה סגורה-למחצה

למרות שהמודל משוחרר במתכונת קוד פתוח, הוא מותאם לפלטפורמות החומרה של אנבידיה: האופטימיזציה ל-CUDA, TensorRT ודיוקי חישוב נמוכים מאפשרת הרצה בזמן אמת על מחשבי DRIVE, שהם הרבה יותר דומים ל-GPU מאשר לשבבי ADAS ייעודיים. בכך Alpamayo משתלב באסטרטגיית הקוד הפתוח הרחבה יותר של אנבידיה, שבמסגרתה היא משחררת מודלים פתוחים לרובוטיקה, אקלים, רפואה ורכב – לאחר שעברו אופטימיזציה עמוקה לפלטפורמות המחשוב שלה. הגישה הזו מאפשרת לאקוסיסטם רחב להיבנות סביב המודלים, ומעניקה יתרון ביצועים ברור למי שבוחר בפלטפורמות של אנבידיה.

איום למודל אחד, הזדמנות לאחרים

מודל הנהיגה של אנבידיה אינו מבשר מהפכה מיידית בכבישים, אך הוא כן מסמן שינוי עמוק באופן שבו תעשיית הרכב חושבת על פיתוח מערכות אוטונומיות: פחות חוקים ידניים, יותר מודלי AI כלליים, יותר חישוב על הרכב, ויותר סימולציה ואימות. עבור חלק גדול מהאוטוטק הישראלי, זהו כיוון שתואם היטב את המוצרים והאסטרטגיה שלהן, ואף עשוי להאיץ אימוץ ושיתופי פעולה בתוך אקוסיסטם ה-DRIVE. עבור מובילאיי, לעומת זאת, זהו איתות לכך שקיימת דרך נוספת לבנות “מוח נהיגה”, שאינה נשענת בהכרח על סטאק סגור מקצה לקצה.